Los robots son programas automatizados, y las arañas son un tipo de robots que se desplazan continuamente por la red, saltando de un lugar a otro con el fin de compilar estadísticas sobre el Web o crear bases de datos con el contenido del mismo (Google, Yahoo, Altavista, Lycos, WebCrawler los utilizan).

Las arañas hacen un valioso trabajo para todos; sin ellas sería imposible crear índices actualizados de la red. Pero también tiene sus desventajas: aumentan el tráfico en la red, además de que una araña mal diseñada puede visitar tantas veces a un sitio que impide el acceso a los usuarios. Tampoco pueden discernir sobre páginas permanentes y temporales, a menos que los sitios que visiten sean concientes de los robots.

¿Cómo funcionan?

Básicamente, un visualizador es un programa que responde a información introducida por el usuario, enviando comandos HTTP (HyperText Transport Protocol - Protocolo de transporte de hipertexto) a través de internet. Las páginas Web son archivos de HTML que contienen texto, códigos de formato y otros datos que definen su contenido.

El visualizador recupera la URL (Uniform Resource Locator - Localizador de recursos uniformes) del destino a la página actual.

Establece una conexión con el servidor remoto, transmite un código Get http para recuperar el archivo HTML y presenta el documento en la pantalla.

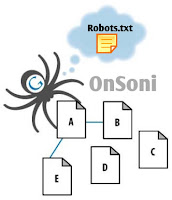

Pues bien, un robot Web es un visualizador con piloto automático. En vez del usuario haciendo clics, el robot baja una página del Web y busca vínculos hacia otros sitios, selecciona una URL y salta hacia ella; desde allí, salta a otro sitio Web y comienza todo de nuevo. Cuando llega a páginas sin vínculos, regresa uno o dos niveles, y salta hacia uno de los que omitió la vez anterior.

¿Qué hacen?

¿Qué hace un robot con las páginas que visita?. Bueno, depende de la razón para lo cual fue creado. Los robots que hacen índices del Web, utilizan algoritmos para generar resúmenes de documentos que se almacenan en inmensas bases de datos.

Otros robots sirven para identificar los vínculos hacia páginas que ya no existen; otros para llevar estadísticas relacionadas con su uso (sitios más populares, por ejemplo), etc.

¿Cómo controlar su comportamiento?

Gracias al SRE (Standard for Robot Exclusion - Estándar para la exclusión de robots), protocolo que permitirá a administradores de sitios indicar instrucciones hacia los distintos robots.

Por ejemplo, se puede indicar que no revisen el contenido completo de un sitio, que no trabajen en las páginas en construcción o no ingrese a directorios que no poseen páginas HTML, haciendo además más eficiente y rápido su trabajo.

Para traspasar las instrucciones deseadas a una araña, sólo debe crearse un archivo de texto denominado "robots.txt".

Este archivo de texto contendrá comandos de un sencillo lenguaje indicando las políticas de acceso de un sitio a estos extraños seres del cyberespacio.

¿Cómo es un archivo robots.txt?

Por ejemplo, a continuación se muestra un archivo sencillo que solicita al robot que se aleje de /onsoni/articulos y de sus subdirectorios.

Más Información

La Página Oficial de Robots.txt

Robots.txt : Todo lo que deberia saber

Las arañas hacen un valioso trabajo para todos; sin ellas sería imposible crear índices actualizados de la red. Pero también tiene sus desventajas: aumentan el tráfico en la red, además de que una araña mal diseñada puede visitar tantas veces a un sitio que impide el acceso a los usuarios. Tampoco pueden discernir sobre páginas permanentes y temporales, a menos que los sitios que visiten sean concientes de los robots.

¿Cómo funcionan?

Básicamente, un visualizador es un programa que responde a información introducida por el usuario, enviando comandos HTTP (HyperText Transport Protocol - Protocolo de transporte de hipertexto) a través de internet. Las páginas Web son archivos de HTML que contienen texto, códigos de formato y otros datos que definen su contenido.

El visualizador recupera la URL (Uniform Resource Locator - Localizador de recursos uniformes) del destino a la página actual.

Establece una conexión con el servidor remoto, transmite un código Get http para recuperar el archivo HTML y presenta el documento en la pantalla.

Pues bien, un robot Web es un visualizador con piloto automático. En vez del usuario haciendo clics, el robot baja una página del Web y busca vínculos hacia otros sitios, selecciona una URL y salta hacia ella; desde allí, salta a otro sitio Web y comienza todo de nuevo. Cuando llega a páginas sin vínculos, regresa uno o dos niveles, y salta hacia uno de los que omitió la vez anterior.

¿Qué hacen?

¿Qué hace un robot con las páginas que visita?. Bueno, depende de la razón para lo cual fue creado. Los robots que hacen índices del Web, utilizan algoritmos para generar resúmenes de documentos que se almacenan en inmensas bases de datos.

Otros robots sirven para identificar los vínculos hacia páginas que ya no existen; otros para llevar estadísticas relacionadas con su uso (sitios más populares, por ejemplo), etc.

¿Cómo controlar su comportamiento?

Gracias al SRE (Standard for Robot Exclusion - Estándar para la exclusión de robots), protocolo que permitirá a administradores de sitios indicar instrucciones hacia los distintos robots.

Por ejemplo, se puede indicar que no revisen el contenido completo de un sitio, que no trabajen en las páginas en construcción o no ingrese a directorios que no poseen páginas HTML, haciendo además más eficiente y rápido su trabajo.

Para traspasar las instrucciones deseadas a una araña, sólo debe crearse un archivo de texto denominado "robots.txt".

Este archivo de texto contendrá comandos de un sencillo lenguaje indicando las políticas de acceso de un sitio a estos extraños seres del cyberespacio.

¿Cómo es un archivo robots.txt?

Por ejemplo, a continuación se muestra un archivo sencillo que solicita al robot que se aleje de /onsoni/articulos y de sus subdirectorios.

[# Ejemplo archivo robots.txt User-agent:* Disallow: /onsoni/articulos ]

Si se desea indicar una orden específica para un robot:La primera línea corresponde a un comentario (#). La segunda línea indica a que robot se le hace la solicitud; en este caso, la orden es para todos (*). La tercera línea muestra a que ruta se le quita el acceso, conjuntamente con los directorios que le siguen en orden jerárquico.

[# Ejemplo archivo robots.txt User-agent:* Disallow: /onsoni/articulos Disallow: /en_contruccion User-agent:Scooter Disallow:]En el ejemplo, el robot Scooter tiene acceso ilimitado dentro del sitio, pero prohibe a otros a ingresar a las rutas especificadas. [Scooter es el robot de AltaVista]. Si desea prohibir el acceso de cualquier robot a su sitio lo mejor sería agregar esto:

[# Ejemplo archivo robots.txt User-agent: * Disallow: /]Robots en Metatags Usted puede utilizar un especial HTML etiqueta para indicar a los robots que no indexen el contenido de una página, y / o no buscar enlaces a seguir. Por ejemplo:

[<html> <head> <title>...</title> <META NAME="ROBOTS" CONTENT="NOINDEX, NOFOLLOW"> </head>]

Hay dos consideraciones importantes cuando se utiliza la etiqueta <META> robots:

- los robots pueden pasar por alto su etiqueta <META>.

Los robots que exploran sobre todo el malware de la web en busca de vulnerabilidades de seguridad, y las cosechadoras dirección de correo electrónico utilizada por los spammers no le prestan atención.

- la Directiva NOFOLLOW sólo se aplica a los enlaces en esta página.

Es totalmente posible que un robot puede encontrar los mismos enlaces en otra página sin NOFOLLOW (tal vez en algún otro sitio), por lo que todavía llega a la página deseada.

No hay que confundir este NOFOLLOW con el atributo rel = "nofollow" atributo de vínculo .

Los detalles

Al igual que el robots.txt / , la etiqueta META robots es un estándar de-facto. Se originó a partir de una "aves del mismo plumaje" reunidos en un taller de indexación distribuida 1996 , y fue descrito en notas de la reunión .

La etiqueta META también se describe en la especificación HTML 4.01, Apéndice B.4.1 .

El resto de esta página ofrece una visión general de cómo utilizar las etiquetas <META> robots en sus páginas, con algunas recetas sencillas.

¿Cómo escribir una etiqueta Meta Robots?

¿Dónde ponerlo?

Al igual que cualquier etiqueta <META> debe ser colocado en la sección HEAD de una página HTML, como en el ejemplo anterior. Usted debe poner en cada página de su sitio, ya que un robot puede encontrar un enlace profundo a cualquier página de su sitio.

¿Qué poner en ella?

El " NOMBRE "atributo debe ser" ROBOTS ".

Los valores válidos para el " CONTENIDO "atributo son:" INDICE "," NOINDEX "," SIGA "," nofollow ".Múltiples valores separados por comas están permitidas, pero, obviamente, sólo algunas combinaciones de sentido. Si no hay etiqueta <META> robots, el valor por defecto es " INDEX, FOLLOW ", así que no hay necesidad de explicar eso. Eso nos deja:[<META NAME="ROBOTS" CONTENT="NOINDEX, FOLLOW"> <META NAME="ROBOTS" CONTENT="INDEX, NOFOLLOW"> <META NAME="ROBOTS" CONTENT="NOINDEX, NOFOLLOW">]Con eso se debería entender bastante sobre el archivo robots.txt y lo necesario que es implementarlo o no.

Más Información